Zuverlässige Optimierung hochdimensionaler Wirkzusammenhänge

Viele industrielle und wirtschaftliche Prozesse unterliegen einer Vielzahl von internen und externen Faktoren, die sich teilweise gegenseitig beeinflussen. Deren mathematische Optimierung über bestimmte Zeiträume hinweg ist hochkomplex und kann erst durch den Einsatz von selbstlernenden Rechenalgorithmen zufriedenstellend gelöst werden.

Praktisch alle Wirtschaftsbereiche, wie Banken, Versicherungen oder Produktionsfirmen, kennen Prozesse, die mehreren Einflussfaktoren unterliegen. Komplex in Ablauf und Vorhersage werden die Prozesse, wenn nicht nur mehrere Faktoren zusammenkommen, sondern diese Faktoren sich beeinflussen und/oder mit externen Rahmenbedingungen abgestimmt werden müssen.

Die Komplexität eines hochdimensionalen Optimierungsproblems mit Nebenbedingungen lässt sich am Beispiel eines Wasserkraftwerks gut illustrieren. In höhergelegenen Sammelbecken werden Regen- und Schmelzwasser gestaut, um damit Turbinen anzutreiben. Dabei darf es weder in der Höhe noch im Tal zu Überflutungen kommen. Je nach Jahreszeit gelten strikte obere und untere Pegelstände für Flora, Fauna und Tourismus. Zudem variieren die Strompreise in Abhängigkeit von Jahreszeit, Wochentag, Tageszeit und Wetterverlauf.

Die zunehmenden Anteile anderer Energiequellen wie Wind und Sonne machen die Preisentwicklungen noch unberechenbarer. Aus betrieblichen Gründen können Betreiber die Turbinen nicht spontan an- und ausschalten, sondern sie erfordern eine minimale Betriebsdauer, und in bestimmten Abständen müssen Unterhaltsarbeiten eingeplant werden. Für die Wirtschaftlichkeit eines Wasserwerks ist ein ausgeklügelter Produktionsplan entscheidend.

Die Herausforderung: realistische Problemlösung in kurzer Zeit

Bei einer Vielzahl von Anwendungen geht es darum, eine beste Strategie zu finden, die in einem möglichst realistischen Modell sämtliche Nebenbedingungen erfüllt, alle Kompromisse abwägt und einer Vielzahl von Risiken und Zufallseffekten gerecht wird. Was so kurz zusammengefasst logisch und lösbar klingt, birgt in der Praxis grosse Schwierigkeiten: Mit klassischen mathematischen Ansätzen und den heutigen handelsüblichen Rechnern muss man entweder die Optimierungsprobleme massiv vereinfachen und damit grössere Standardabweichungen zulassen/unerkannte neue Risiken zulassen. Oder die Rechenzeiten verlängern sich um Jahrhunderte, um eine zufriedenstellende Lösung zu erhalten.

Das Problem dahinter ist der so genannte «Fluch der Dimensionalität»: Die Laufzeit von Optimierungsalgorithmen wächst typischerweise exponentiell mit der Anzahl der Dimensionen. Selbst wenn die Laufzeit für eine Dimension 1 Millisekunde dauert und mit jeder Dimension um den Faktor 1000 wächst, hätte man für ein einfaches Modell in sechs Dimensionen die Berechnung bereits in der letzten Eiszeit starten müssen, um heute das Resultat dieses einen Problems zur Verfügung zu haben.

Die Lösung: Bewerten statt Berechnen mit Reinforcement Learning

Durch die Zusammenarbeit von Dr. Thomas Krabichler vom Kompetenzzentrum Banking & Finance am IFU Institut für Unternehmensführung der OST und Prof. Dr. Josef Teichmann, Stochastic Finance Group der ETH Zürich, gelang es der Arbeitsgruppe, eine effiziente Lösung für das Zeitproblem zu entwickeln. Ihre Methode für das sogenannte Deep Asset-Liability-Management (ALM) löst komplexe und hochdimensionale Optimierungsprobleme entlang einer Zeitachse dank der Kombination von sich selbst verstärkenden Lernprozessen (Reinforcement Learning) mit einem veränderten Denkansatz.

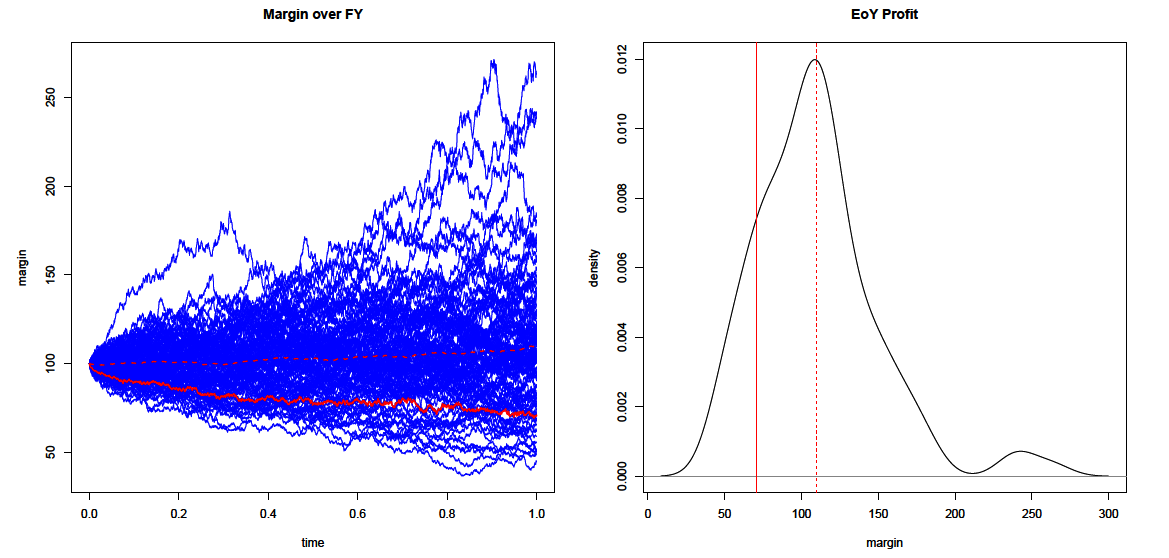

Der entscheidende Lösungsansatz liegt in einem Paradigmenwechsel: Das Modell versucht nicht, das mathematische Problem in aller Allgemeinheit zu lösen. Das Modell untersucht, wie sich eine äusserst schlaue und verlässliche Person verhalten würde, die übermenschlich viele Erfahrungen gesammelt hat. Der Algorithmus sucht also nicht nach einem bestmöglichen Lösungsansatz, sondern beurteilt gegebene Lösungsansätze und entwickelt von dort ausgehend Variationen davon. Das Reinforcement Learning nutzt das aus, indem in wenigen Sekunden ein sehr grosser Erfahrungsschatz gesammelt wird und dadurch in kleinen Schritten die Performance laufend verbessert wird. Dadurch gelingt es, den «Fluch der Dimensionalität» zu durchbrechen. Dieselbe Technik wurde beispielsweise vom auf das Brettspiel Go spezialisierte Computerprogramm DeepMind eingesetzt, das dank ähnlicher Muster den Go-Weltmeister schlagen konnte. Der Durchbruch bei der nun möglichen kurzen Rechenzeit hat einen grossen sozialen und wirtschaftlichen Einfluss.

Realistische Szenarien und schnelle Rechenzeiten für eine wirtschaftliche Optimierung

Grundlage der Technik ist die Modellierung möglichst realistischer Szenarien. Darüber hinaus muss eine virtuelle Umgebung programmiert werden, in der zum Beispiel eine künstliche Finanzagentin anhand der Spielregeln, einem vernünftigen Risikoappetit und den besagten Szenarien ihren Erfahrungsschatz sammeln kann. Dies erzielt man durch ein Anreizsystem, das Belohnungen für erwünschtes Verhalten oder erstrebenswerte Resultate verteilt. Hält sich die Finanzagentin nicht an die Spielregeln oder vernachlässigt Nebenbedingungen, wird das im Anreizsystem mit Penalties berücksichtigt.

Die Swiss Risk Association ehrte die gemeinsame Arbeit mit dem Swiss Risk Award 2020.

Kontakt

Prof. Dr. Thomas KrabichlerIFL Institut für Finance und LawKompetenzzentrum Banking und Finance

+41 58 257 12 18thomas.krabichler@ost.ch

Weiterführende Literatur

- Publikation Deep ALM

- Foliensammlung New Frontiers in Quantitative Risk Management